Proxmox VE 7.x(1) - セットアップとssacli(HPのRAIDユーティリティ)とstorcli(富士通MegaRAIDユーティリティ)の導入

Proxmox VEはdebianベースの仮想基盤です。2023/5現在、最新リリースバージョンはProxmox VE 7.4で、ベースOSにはdebian11(bullseye)が使われています。手持ちのVMware vSphereではWindows11ゲスト導入に問題があったのでProxmox VE7.4の環境を作ってみました。サーバはHPと富士通です。

前半でProxmox VE7.4の導入、後半でWindows11のインストールを紹介します。

サーバ環境 1台目

部屋に落ちていたかなり古い HPサーバMicroserver Gen8でCPUはE3-1220 v2です。nvme直結で作ってしまうと壊れたらおしまいなのでハードウェアRAIDカードP222 +1TB SATA-SSDx2本でRAID1とします。

サーバ環境 2台目

富士通 TX1320 M3でCPUはE3-1240 v6 を1台追加しました。こちらも標準のハードウェアRAIDカードD3216 (EP400i) +1TB SATA-SSDx2本でRAID1 です。

公式サイトからISOをダウンロードしてサーバにインストール。

特に問題なくインストールできます。すべてデフォルトでインストールするとストレージ全体がパーティション1つLVMになります。あとでNFSでストレージもくっつけられますからこれで大丈夫。仮想マシンはLVMボリュームが毎回作られます。

Proxmox-VEの管理用URLはhttps://xxx.xxx.xxx.xxx:8006

このURL画面からいろいろ設定していきますがベースがdebianなのでもちろんsshで入って作業もできます。

ディスクを確認しておきます。

パーィション

DISKは2TB以下のDISKでもMBRではなくgptで、/dev/sda1がBIOS Boot、/dev/sda2がEFI、そして残りすべて/dev/sda3がLVMのPV(Physical Volume)にパーティションが作成されます。そしてsda3のPVはすべてVG(Volime Group)がVG名「pve」で作られます。

このVGからLVMでOSシステム用にswapに8G、/に約100G(96G)が切り出された後の、残り全体をシンプールdataを作り、そこからシンロジカルボリュームで仮想マシンストレージがして作られていく。という雰囲気になります。

WebGUIでインストール用のISOをアップロードするとき約100Gの/パーティションに置かれます。まぁゲストOSインストールのISOを置く場所の容量は100Gもあれば十分でしょう。DISKが足らなければISO置き場やバックアップ用にあとでUSB-DISKをマウントしてもいいかもです。

パーティションを見てみます。fdiskだけでpartedは入ってないですね。

root@pve:~# fdisk /dev/sda Welcome to fdisk (util-linux 2.36.1). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Command (m for help): p Disk /dev/sda: 931.48 GiB, 1000171331584 bytes, 1953459632 sectors Disk model: LOGICAL VOLUME Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 4096 bytes I/O size (minimum/optimal): 262144 bytes / 262144 bytes Disklabel type: gpt Disk identifier: 5B26829B-0A36-4481-809F-BD4EB1B0DB88 Device Start End Sectors Size Type /dev/sda1 34 2047 2014 1007K BIOS boot /dev/sda2 2048 2099199 2097152 1G EFI System /dev/sda3 2099200 1953459598 1951360399 930.5G Linux LVM Partition 1 does not start on physical sector boundary.

dfで見るとこんな感じになります。

root@pve:~# df Filesystem 1K-blocks Used Available Use% Mounted on udev 8126388 0 8126388 0% /dev tmpfs 1632020 948 1631072 1% /run /dev/mapper/pve-root 98497780 8476084 84972148 10% / tmpfs 8160092 46800 8113292 1% /dev/shm tmpfs 5120 0 5120 0% /run/lock /dev/fuse 131072 16 131056 1% /etc/pve tmpfs 1632016 0 1632016 0% /run/user/0

LVMの様子です。メモリは16GBのサーバですがswapは8GBが自動設定されています。

root@pve:~# pvdisplay --- Physical volume --- PV Name /dev/sda3 VG Name pve PV Size 930.48 GiB / not usable 4.69 MiB Allocatable yes PE Size 4.00 MiB Total PE 238202 Free PE 4095 Allocated PE 234107 PV UUID FkGcbL-jlLe-Eg0u-mfva-ZDbY-3xU4-d2hZ6p root@pve:~# vgdisplay --- Volume group --- VG Name pve System ID Format lvm2 Metadata Areas 1 Metadata Sequence No 9 VG Access read/write VG Status resizable MAX LV 0 Cur LV 4 Open LV 2 Max PV 0 Cur PV 1 Act PV 1 VG Size <930.48 GiB PE Size 4.00 MiB Total PE 238202 Alloc PE / Size 234107 / 914.48 GiB Free PE / Size 4095 / <16.00 GiB VG UUID 9RuSc1-nxEA-jIZn-TYrv-3EVE-3WCp-CAoS2I root@pve:~# lvdisplay --- Logical volume --- LV Path /dev/pve/swap LV Name swap VG Name pve LV UUID V4dTqw-P5uM-ehyp-2tqD-7otq-0YBw-ZMPpHD LV Write Access read/write LV Creation host, time proxmox, 2023-05-06 21:02:23 +0900 LV Status available # open 2 LV Size 8.00 GiB Current LE 2048 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 1024 Block device 253:0 --- Logical volume --- LV Path /dev/pve/root LV Name root VG Name pve LV UUID tGd8Gx-xRce-2JUQ-1aRi-Sv2N-Krpv-VolUD3 LV Write Access read/write LV Creation host, time proxmox, 2023-05-06 21:02:23 +0900 LV Status available # open 1 LV Size 96.00 GiB Current LE 24576 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 1024 Block device 253:1 これが仮想マシン用のシンプールです。シンプールと言ってもLogical volumeです。 --- Logical volume --- LV Name data VG Name pve LV UUID 3paIdV-nWvZ-fSUw-g2yQ-xNbn-CXC0-2upnXy LV Write Access read/write (activated read only) LV Creation host, time proxmox, 2023-05-06 21:03:03 +0900 LV Pool metadata data_tmeta LV Pool data data_tdata LV Status available # open 0 LV Size <794.27 GiB Allocated pool data 1.57% Allocated metadata 0.29% Current LE 203333 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 1024 Block device 253:5 シンプールに作られる仮想マシンのシンロジカルボリュームです。ゲストには100番から順に通し番号が振られてその番号でストレージが作られます。これはゲストにWindows10を作って32GBのLVMが作ったところです。 --- Logical volume --- LV Path /dev/pve/vm-100-disk-0 LV Name vm-100-disk-0 VG Name pve LV UUID y4Oj0p-iD1l-FZZY-2pQb-Td5z-1hD6-qZhECl LV Write Access read/write LV Creation host, time pve, 2023-05-06 21:34:04 +0900 LV Pool name data LV Status available # open 0 LV Size 32.00 GiB Mapped size 39.04% Current LE 8192 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 1024 Block device 253:6

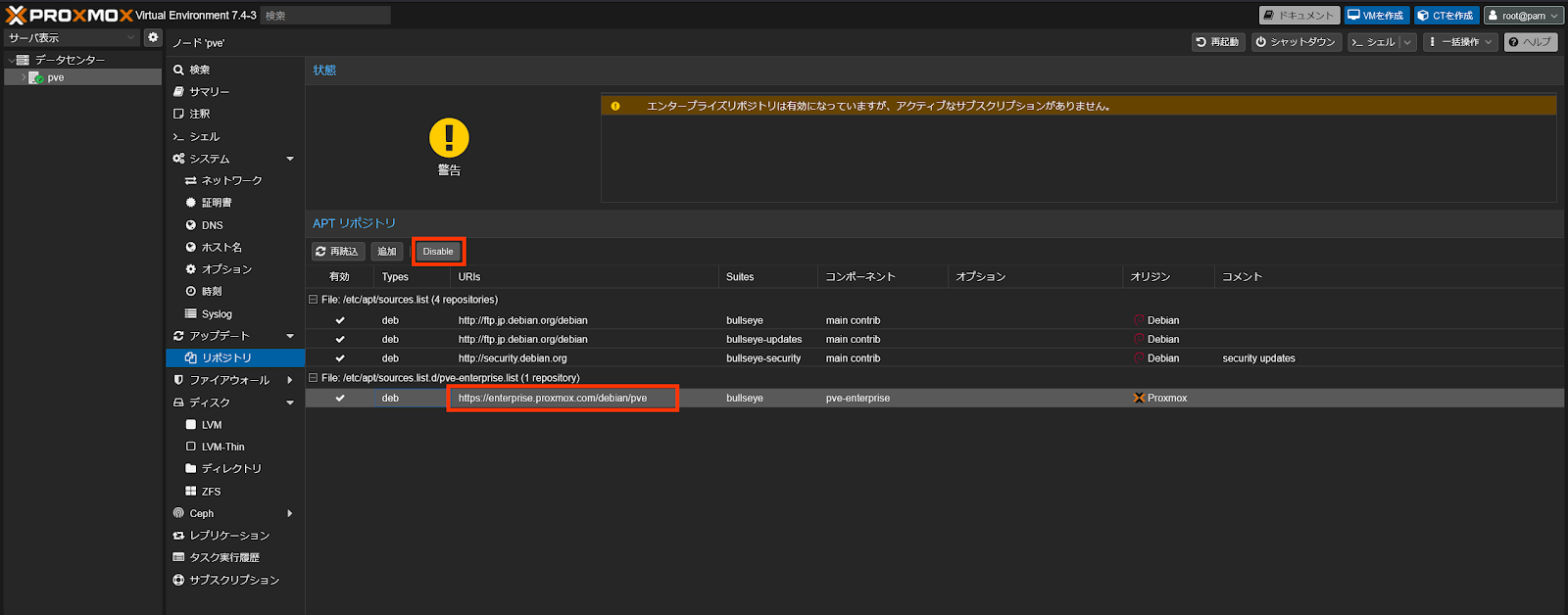

無償版レポジトリ設定

デフォルトでは有料契約者向けのEnterpriseレポジトリが設定されています。非契約者向けのレポジトリに変更してアップデートできるようにします。公式手順やBlogには、直接レポジトリファイルを修正する手順は紹介されていますが、WebGUIからすべてできるようになりました。

公式手順 Proxmox VE No-Subscription Repository

https://pve.proxmox.com/wiki/Package_Repositories#sysadmin_no_subscription_repo

メニューからpve>レポジトリを開きます。

Enterpriseレポジトリを選んで「disable」ボタンを押し無効にします。

「追加」ボタンで「No-Subscription」レポジトリを追加します。

表示されるメッセージは「本番には保証されません」というものです。

This is the recommended repository for testing and non-production use. Its packages are not as heavily tested and validated as the production ready enterprise repository. You don't need a subscription key to access this repository.

これは、テスト用および本番以外での使用に推奨されるリポジトリです。そのパッケージは、本番対応のエンタープライズ リポジトリほど厳密にテストおよび検証されていません。このリポジトリにアクセスするためにサブスクリプション キーは必要ありません。

HP機:RAIDユーティリティ ssacliツールをレポジトリから導入

HPは自社ハードウェア用のレポジトリを公開しています。

今回使うのはこのうち、mcp (Management Component Pack)です。

レポジトリを追加してssacliをインストールします。

手順

mrpeardotnet/PVE-HP-ssacli-smart-storage-admin.md

HP Smart Storage Admin CLI (ssacli) installation and usage on Proxmox PVE (6.x)

https://gist.github.com/mrpeardotnet/a9ce41da99936c0175600f484fa20d03

レポジトリ追加

Debian9 echo "deb http://downloads.linux.hpe.com/SDR/repo/mcp stretch/current non-free" > /etc/apt/sources.list.d/hp-mcp.list Debian10 buster echo "deb http://downloads.linux.hpe.com/SDR/repo/mcp buster/current non-free" > /etc/apt/sources.list.d/hp-mcp.list Debian11 bullseye echo "deb http://downloads.linux.hpe.com/SDR/repo/mcp bullseye/current non-free" > /etc/apt/sources.list.d/hp-mcp.list

PGPキー

wget -q -O - http://downloads.linux.hpe.com/SDR/hpPublicKey1024.pub | apt-key add - wget -q -O - http://downloads.linux.hpe.com/SDR/hpPublicKey2048.pub | apt-key add - wget -q -O - http://downloads.linux.hpe.com/SDR/hpPublicKey2048_key1.pub | apt-key add - wget -q -O - http://downloads.linux.hpe.com/SDR/hpePublicKey2048_key1.pub | apt-key add -

Installing the ssacli package

apt update apt install ssacli

レポジトリの追加が終わったところ。

ssacliでステータス取得

ssacli ctrl all show でPCIスロット番号を取得して>Smart Array P222 in Slot 1 (sn: PDSXH0BRH6F0FH)

カードの状態。バッテリステータスはこちらで取得

ssacli ctrl slot=1 show

>Battery/Capacitor Status: OK

ロジカルドライブの状態

ssacli ctrl slot=1 logicaldrive all show

>logicaldrive 1 (1.82 TB, RAID 1, OK)

物理DISKの状態

ssacli ctrl slot=1 physicaldrive all show

>physicaldrive 2I:0:1 (port 2I:box 0:bay 1, SATA HDD, 250 GB, OK)

>physicaldrive 2I:0:2 (port 2I:box 0:bay 2, SATA HDD, 250 GB, OK)

>physicaldrive 2I:0:3 (port 2I:box 0:bay 3, SATA HDD, 250 GB, OK)

>physicaldrive 2I:0:4 (port 2I:box 0:bay 4, SATA HDD, 250 GB, OK)

富士通機:MegaRAIDユーティリティ storcliツールを導入

このRAIDカードは、元は製造メーカーはLSI>Broadcomになっています。Braodcomのサイトで配布している最新版は動作しませんでしたのでおとなしく富士通サイトから純正ツールをダウンロードします。ドライバはOS標準で認識するので問題ありません。

PRIMERGY ドライバダウンロードページから「PRIMERGY TX1320 M3 (SSD-240GB×2標準搭載、2.5インチ/250W電源×1) / PYT132S3CX」でRAIDで検索。

https://azby.fmworld.net/app/customer/driversearch/ia/drviaindex?

からLSI MegaRAID controller configuration utility - StorCli

https://azby.fmworld.net/app/customer/driversearch/ia/drviadownload?driverNumber=F1027524

WindowsPCでexeを展開するとWindows用/Linux用が出てくる。rpmしかないので展開して手動で /opt/以下に配置すればOK。

*同じところからファームも入手できます。WindowsPCでexeを展開するとWindows用/Linux用が出てくる。今回アップデートはしませんでしたがRedhat/Ubuntu/Windows用なので、UbuntuのLiveCDで立ち上げて実行すればよさそうです。storcliでステータス取得

詳しくはこちらを参照https://ktaka.blog.ccmp.jp/2013/05/megaraidstorcli.html

カード概要の取得。cがカード番号で0から順に振られます。デグレードDgd=Degradedになっていないか確認します。 storcli show カードとボリューム指定して。c0カード番号と、v0ボリューム番号を指定します。 storcli /c0/v0 show 全部を表示するにはこちら。 storcli /call show

キャッシュの確認

/opt/MegaRAID/storcli/storcli /c0/v0 showCacheが「RWTD」になっています。これは

/opt/MegaRAID/storcli/storcli /c0/v0 set wrcache=AWB以下詳細です。

root@pve1:/opt/MegaRAID/storcli# /opt/MegaRAID/storcli/storcli /call show Generating detailed summary of the adapter, it may take a while to complete. CLI Version = 007.0709.0000.0000 Aug 14, 2018 Operating system = Linux 5.15.107-2-pve Controller = 0 Status = Success Description = None Product Name = PRAID EP400i Serial Number = 0000000053787338 SAS Address = 50030057029556a0 PCI Address = 00:01:00:00 System Time = 05/23/2023 15:10:56 Mfg. Date = 00/00/00 Controller Time = 05/23/2023 06:10:57 FW Package Build = 24.16.0-0105 BIOS Version = 6.32.02.1_4.17.08.00_0x06150501 FW Version = 4.660.00-8175 Driver Name = megaraid_sas Driver Version = 07.717.02.00-rc1 Vendor Id = 0x1000 Device Id = 0x5D SubVendor Id = 0x1734 SubDevice Id = 0x11F6 Host Interface = PCI-E Device Interface = SAS-12G Bus Number = 1 Device Number = 0 Function Number = 0 Drive Groups = 1 TOPOLOGY : ======== --------------------------------------------------------------------------- DG Arr Row EID:Slot DID Type State BT Size PDC PI SED DS3 FSpace TR --------------------------------------------------------------------------- 0 - - - - RAID1 Optl N 931.0 GB dflt N N none N N 0 0 - - - RAID1 Optl N 931.0 GB dflt N N none N N 0 0 0 252:0 1 DRIVE Onln N 931.0 GB dflt N N none - N 0 0 1 252:1 3 DRIVE Onln N 931.0 GB dflt N N none - N --------------------------------------------------------------------------- DG=Disk Group Index|Arr=Array Index|Row=Row Index|EID=Enclosure Device ID DID=Device ID|Type=Drive Type|Onln=Online|Rbld=Rebuild|Dgrd=Degraded Pdgd=Partially degraded|Offln=Offline|BT=Background Task Active PDC=PD Cache|PI=Protection Info|SED=Self Encrypting Drive|Frgn=Foreign DS3=Dimmer Switch 3|dflt=Default|Msng=Missing|FSpace=Free Space Present TR=Transport Ready Virtual Drives = 1 VD LIST : ======= ------------------------------------------------------------- DG/VD TYPE State Access Consist Cache Cac sCC Size Name ------------------------------------------------------------- 0/0 RAID1 Optl RW Yes RWTD - OFF 931.0 GB ------------------------------------------------------------- Cac=CacheCade|Rec=Recovery|OfLn=OffLine|Pdgd=Partially Degraded|Dgrd=Degraded Optl=Optimal|RO=Read Only|RW=Read Write|HD=Hidden|TRANS=TransportReady|B=Blocked| Consist=Consistent|R=Read Ahead Always|NR=No Read Ahead|WB=WriteBack| AWB=Always WriteBack|WT=WriteThrough|C=Cached IO|D=Direct IO|sCC=Scheduled Check Consistency Physical Drives = 2 PD LIST : ======= ----------------------------------------------------------------------------------- EID:Slt DID State DG Size Intf Med SED PI SeSz Model Sp Type ----------------------------------------------------------------------------------- 252:0 1 Onln 0 931.0 GB SATA SSD N N 512B Samsung SSD 870 EVO 1TB U - 252:1 3 Onln 0 931.0 GB SATA SSD N N 512B Samsung SSD 870 EVO 1TB U - ----------------------------------------------------------------------------------- EID-Enclosure Device ID|Slt-Slot No.|DID-Device ID|DG-DriveGroup DHS-Dedicated Hot Spare|UGood-Unconfigured Good|GHS-Global Hotspare UBad-Unconfigured Bad|Onln-Online|Offln-Offline|Intf-Interface Med-Media Type|SED-Self Encryptive Drive|PI-Protection Info SeSz-Sector Size|Sp-Spun|U-Up|D-Down/PowerSave|T-Transition|F-Foreign UGUnsp-Unsupported|UGShld-UnConfigured shielded|HSPShld-Hotspare shielded CFShld-Configured shielded|Cpybck-CopyBack|CBShld-Copyback Shielded

おまけ1:HP P222ストレージのベンチマーク。

Xeon E3 v2世代では P222+1TB SATA-SSDx2 RAID1のシーケンシャルREADで516MB/s程度です。

root@pve:~# fio -filename=/tmp/test2g -direct=1 -rw=read -bs=4k -size=2G -numjobs=64 -runtime=10 -group_reporting -name=file1

file1: (g=0): rw=read, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=psync, iodepth=1

...

fio-3.25

Starting 64 processes

file1: Laying out IO file (1 file / 2048MiB)

Jobs: 64 (f=64): [R(64)][100.0%][r=472MiB/s][r=121k IOPS][eta 00m:00s]

file1: (groupid=0, jobs=64): err= 0: pid=4705: Tue May 9 21:29:33 2023

read: IOPS=126k, BW=492MiB/s (516MB/s)(4921MiB/10006msec)

clat (usec): min=52, max=12659, avg=507.02, stdev=134.59

lat (usec): min=52, max=12660, avg=507.12, stdev=134.59

clat percentiles (usec):

| 1.00th=[ 273], 5.00th=[ 326], 10.00th=[ 363], 20.00th=[ 416],

| 30.00th=[ 441], 40.00th=[ 461], 50.00th=[ 506], 60.00th=[ 529],

| 70.00th=[ 553], 80.00th=[ 586], 90.00th=[ 652], 95.00th=[ 693],

| 99.00th=[ 906], 99.50th=[ 1012], 99.90th=[ 1500], 99.95th=[ 1680],

| 99.99th=[ 2376]

bw ( KiB/s): min=456240, max=576950, per=100.00%, avg=504684.55, stdev=509.18, samples=1219

iops : min=114060, max=144229, avg=126170.68, stdev=127.27, samples=1219

lat (usec) : 100=0.01%, 250=0.60%, 500=48.36%, 750=47.80%, 1000=2.68%

lat (msec) : 2=0.52%, 4=0.02%, 10=0.01%, 20=0.01%

cpu : usr=0.43%, sys=1.50%, ctx=1279342, majf=0, minf=927

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=1259673,0,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=1

Run status group 0 (all jobs):

READ: bw=492MiB/s (516MB/s), 492MiB/s-492MiB/s (516MB/s-516MB/s), io=4921MiB (5160MB), run=10006-10006msec

Disk stats (read/write):

dm-1: ios=1250536/8, merge=0/0, ticks=600624/0, in_queue=600624, util=98.87%, aggrios=943600/5, aggrmerge=316077/3, aggrticks=452730/7, aggrin_queue=452736, aggrutil=98.65%

sda: ios=943600/5, merge=316077/3, ticks=452730/7, in_queue=452736, util=98.65%

おまけ2:富士通 D3216 (EP400i) ストレージのベンチマーク。

Xeon E3 v6世代 D3216 (EP400i) +1TB SATA-SSDx2 RAID1のシーケンシャルREADで618MB/s程度です。少し速いですがCPUの違いなのかなというところ。

root@pve1:~# fio -filename=/tmp/test2g -direct=1 -rw=read -bs=4k -size=2G -numjobs=64 -runtime=10 -group_reporting -name=file1

file1: (g=0): rw=read, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=psync, iodepth=1

...

fio-3.25

Starting 64 processes

file1: Laying out IO file (1 file / 2048MiB)

Jobs: 64 (f=64): [R(64)][100.0%][r=595MiB/s][r=152k IOPS][eta 00m:00s]

file1: (groupid=0, jobs=64): err= 0: pid=3506: Tue May 23 14:43:49 2023

read: IOPS=151k, BW=590MiB/s (618MB/s)(5899MiB/10002msec)

clat (usec): min=49, max=6376, avg=422.95, stdev=88.88

lat (usec): min=50, max=6376, avg=423.08, stdev=88.87

clat percentiles (usec):

| 1.00th=[ 338], 5.00th=[ 347], 10.00th=[ 351], 20.00th=[ 355],

| 30.00th=[ 363], 40.00th=[ 429], 50.00th=[ 433], 60.00th=[ 437],

| 70.00th=[ 441], 80.00th=[ 445], 90.00th=[ 461], 95.00th=[ 515],

| 99.00th=[ 783], 99.50th=[ 873], 99.90th=[ 1172], 99.95th=[ 1287],

| 99.99th=[ 2114]

bw ( KiB/s): min=575112, max=615352, per=100.00%, avg=604344.84, stdev=211.84, samples=1216

iops : min=143778, max=153838, avg=151086.00, stdev=52.97, samples=1216

lat (usec) : 50=0.01%, 250=0.01%, 500=94.79%, 750=3.89%, 1000=1.07%

lat (msec) : 2=0.24%, 4=0.01%, 10=0.01%

cpu : usr=0.53%, sys=2.00%, ctx=1510757, majf=1, minf=933

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=1510247,0,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=1

Run status group 0 (all jobs):

READ: bw=590MiB/s (618MB/s), 590MiB/s-590MiB/s (618MB/s-618MB/s), io=5899MiB (6186MB), run=10002-10002msec

Disk stats (read/write):

dm-1: ios=1505189/69, merge=0/0, ticks=619800/196, in_queue=619996, util=98.91%, aggrios=1364573/39, aggrmerge=145678/30, aggrticks=563684/96, aggrin_queue=563780, aggrutil=98.72%

sda: ios=1364573/39, merge=145678/30, ticks=563684/96, in_queue=563780, util=98.72%

セットアップは以上です。次回はWindows11インストール。

コメント

コメントを投稿